Всем здравствуйте. Сегодня я расскажу о том, какие ошибки в сео-оптимизации мешают продвижению сайтов, ранжированию и достижению ими ТОПа в выдаче поисковых систем.

Но не просто расскажу про какие-то абстрактные ошибки, я разбил их на 3 части.

- Одна из частей будет более абстрактной – это когда сайт не ранжируется совсем, вообще нет ни позиций, не растет ничего.

А ещё две части:

- первая – посвящена ошибкам при работе с запросами, ключевыми словами, в подготовке;

- вторая – будет направлена, наверное, на самый актуальный вопрос – SEO-тексты. Нужно их писать, не нужно их писать, если писать, то как, и что вообще делать.

Ошибки при работе с ключевыми фразами

Начать бы хотелось с ключевых слов/фраз (поисковые запросы, по которым вы бы хотели ранжироваться в поиске) – это самый старт продвижения, т.е. одно из основополагающих успеха.

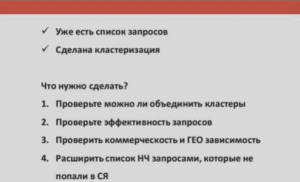

Как правило, ошибка не в сборе запросов, ошибка не в кластеризации – ошибка после того, как уже эти две работы проведены. Т.е. когда мы подобрали семантическое ядро сайта, список тех запросов, которые продвигать, когда мы их кластеризировали (вручную или при помощи сервисов) – что можно и нужно сделать дальше для того, чтобы продвижение было успешным?

- Проверить, можно ли объединить кластеры. Т.е. может получиться так, что те кластеры ключевых слов, которые были созданы, они либо не полные, либо наоборот слишком объёмные. Нужно проверить обязательно вручную (особенно, если вы делали в сервисе), корректно ли составлены кластеры.

- Проверить эффективность запросов с точки зрения расстановки приоритетов: с чего начинать, какой из кластеров наиболее эффективен с точки зрения продвижения. Т.е. если вы продвинете, то вы получите большее количество трафика.

- Не забываем о проверке “коммерческости” и ГЕО зависимости.

- И, что самое интересное, при работе по трафику не нужно забывать о том, что нужно дособирать НЧ запросы под кластер, если вы сделали кластер

неполным.

Теперь чуть более подробно про эти пункты.

Эффективность запросов

Попробую в простом примере рассказать, как можно оценить. Естественно, про эффективность запросов нужно более глубоко и подробно в них

погружаться. Есть курсы про это у Дмитрия Иванова, который рассказывает, как эффективно просчитать, сделать корень по запросам и по многим,

многим факторам. Мы попробуем сделать это чуть проще.

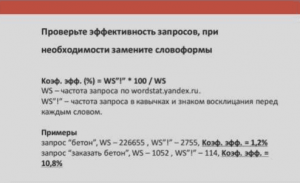

Чтобы нам расставить приоритеты в продвижении, попробуем просто собрать в WordStat частоту общую и точную. И посчитать в процентах соотношение. Тем самым, мы получим для ВЧ запросов, что эффективность от их продвижения будет крайне мала. Естественно, не во всех нишах, но в большинстве.

Что при продвижении ВЧ запросов эффективность будет мала: мы потратим много времени, много усилий, возможно, много денег и нервов. Чтобы получить небольшую долю трафика по этим запросам. И наоборот. Чем более НЧ запрос, тем будет выше его эффективность.

Соответственно, те кластеры, где активность будет максимальной, имеет смысл продвигать в первую очередь. Единственное, на что хочу обратить

внимание: нужно считать совокупную эффективность кластера, а не каждого конкретного запроса. Иначе у вас будет 100% эффективность у НЧ запросов – это будет не совсем корректно. Вот на это нужно обращать внимание: считать эффективность целого кластера и, исходя из этого, брать в продвижение.

Делаем кластеризацию на сервисах. Используем платный/бесплатный сервис – их сейчас очень много, все работают примерно +/- одинаково. Но суть в следующем, что мы на выходе получаем кластера запросов – группы, по которым сервис раскидал наше семантическое ядро. И предполагаем, что одна группа ключевых фраз – это одна страница.

Соответственно, прежде чем это брать в продвижение, нужно проверить.

Т.е. нужно проверять логически группы, могут ли совпадать в один кластер. Или наоборот, может быть кластер составлен некорректно. Например, вы

использовали soft-кластеризацию, и у вас получились очень большие кластеры. Это некорректно при продвижении по позициям достаточно

частотных запросов.

Важно обращать на это внимание. Это может быть причиной, почему сайты не продвигаются по таким-то запросам.

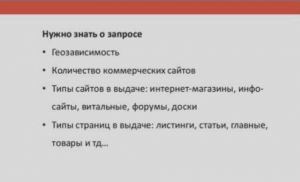

Что нужно обязательно знать о поисковом запросе:

- Геозависимость.

- Количество коммерческих сайтов.

- Типы сайтов в выдаче: интернет-магазины, информационные сайты, витальные, доски, форумы.

- Типы страниц в выдаче: листинги, статьи, главные страницы, товары и т.д.

Геозависимость запроса, его “коммерческость”, какие сайты в выдаче, какой контент у этих сайтов – обязательно на это обращайте внимание.

Например, при запросе “маникюр” мы увидим, что в выдаче будут в основном одни сайты информационного характера. Это нужно учитывать при проработке ключевых фраз. Т.е. мы должны понимать риск, что, продвигаясь по запросам, связанным с маникюром, без слова «цена», «салон красоты», «сделать в салоне» и т.д., будет достаточно сложно попасть в эти ТОПы.

По запросу “стоматология” – аналогично. Мы видим, что выдача очень разнообразна: здесь есть и агрегаторы, и клиники, и сеть клиник. И если у вас просто один стоматологический кабинет в каком-то районе Москвы, будет очень сложно продвинуться в эту выдачу.

Т.е. изначально не нужно идти туда, где нет сайтов вашего типа, или их очень мало.

Как пример, это жилые комплексы, которые хотят продвигаться по запросу «купить новостройку в каком-то районе». Там будут в основном одни

агрегаторы. Причем будут забиты ТОП-20, ТОП-30 одними агрегаторами. Бороться с ними будет практически нереально. Там используют другие виды продвижения (интернет-маркетинг).

Коммерческость запросов

Это можно делать автоматически. Вот у ребят из Pixelplus есть отличный инструмент, который помогает в определении коммерческости и в локализации, в определении геозависимости. Можно использовать его.

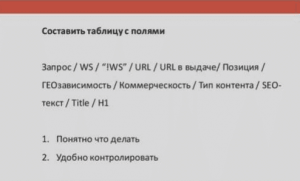

Очень удобно, чтобы контролировать всё, что связано с запросами, интентами, типами контента и т.д., делать табличку. По механике работы она достаточно старая. Мы её используем много-много лет, но тем самым она не потеряла своей актуальности.

Составляем её в Excel:

| Запрос | Частота | Частота точная | Продвигаемый URL | URL в выдаче | Позиция в Яндекс, Гугл | Геозависимость | Коммерческость | Тип контента | Нужен ли SEO-текст | Title | H1 |

| Запрос 1 | |||||||||||

| Запрос 2 | |||||||||||

| Запрос 3 |

Запрос / Частотность запроса / Частотность запроса точная / URL (который мы продвигаем) / URL в выдаче (который находится в поисковой выдаче) / Позиция в Яндекс, Позиция в Гугл / Геозависимость (или локализацию запроса) / Коммерческость / Тип контента / Необходим нам SEO-текст или нет / Title / H1.

И всё это можно контролировать, периодически пересобирая все данные для того, чтобы понимать, что происходит с нашими запросами. Будет всё сразу видно: перебилась ли релевантная страница, изменился ли интент, какой тип контента выдачи и т.д.

Таким образом это нужно всё пересобирать раз в какое-то время. Соответственно, вы сможете контролировать всё, что связано с вашими запросами и понимать, ошиблись вы где-то или нет.

Ошибки в seo-текстах

Пункт второй у нас был про SEO-тексты. На самом деле очень много вопросов в последнее время, что делать с SEO-текстами: писать/не писать, накажут/не накажут, а как же с Гуглом.

Тут нас ждёт несколько трудностей, но при этом нужно чётко понимать, что вообще контент нужен. Обязательно ли нужен или нет – это вопрос, который сейчас нужно будет разобрать.

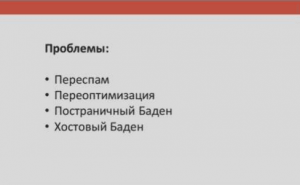

Вообще, что нас ждёт при подготовке текстового контента. Неважно – коммерческих или информационных:

- Переспам.

- Переоптимизация.

- Постраничный “Баден” (фильтр Яндекса, который накладывается на определённую страницу сайта, когда по версии ПС текст на ней является малополезным для пользователей).

- Хостовый “Баден” (этот фильтр накладывается на весь сайт целиком).

Это с точки зрения Яндекс. Про Гугл мы поговорим чуть позже отдельно.

Соответственно, при подготовке оптимизации как сейчас происходит процесс:

- Получение ТОПов по запросам.

- Выбор подходящих по типу сайтов/страниц.

- Анализ содержания сайта.

- Анализ контента на целевой странице.

Мы смотрим по ТОПам, что в них происходит. Смотрим, какой тип контента, есть ли там SEO-тексты. Если есть – какого размера. Обязательно смотрим по соответствию к нашему типу сайта нашему типу страницы. Так же проводим анализ всего содержания сайта, и что непосредственно в контенте.

Т.е. не просто, что там листинг, а какой размер листинга. Не просто наличие текстового контента, а как он расположен, где расположен, какой

объем, есть ли картинки и т.д.

Исходя из того, что мы увидели в ТОПе по запросам, мы принимаем решение: будет SEO-текст писаться или нет.

Мы делали исследование. Правда, достаточно давно, но плюс-минус данные не поменялись. Мы выгружали данные из одного сервиса. Мы видим, что при отсутствии вхождений в контент, как факт, как всего запроса, так и слов из запроса, у сайтов наблюдаются проблемы с ранжированием, сайты не достигают ТОПа, если у них нет вхождений.

Это не говорит о том, что надо обязательно писать текст, но понимать это нужно.

Как проверить: нужен текст, не нужен текст, какие нужны вхождения.

Мы можем воспользоваться текстовым анализатором, чтобы сделать блок-схему. Благо, их тоже сейчас много: платные/бесплатные, абсолютно разные. И проверяем там.

Мы вбиваем запросы и смотрим, что рекомендуется в ТОПе, как у сайтов в ТОПе. И смотрим данные.

Например, что нужно вхождение в title, вхождение в Тег <a>, вхождение во фрагмент текста, в SEO-текст. И смотрим зоны этих текстов.

Например, если у нас зона SEO-текста, как таковая, отсутствует… Допустим, объем в словах –100 слов. Это фактически отсутствие SEO-текста. Это просто небольшой абзац с текстом. Это немного – соответственно, где весь контент? Все ключевые фразы могут находится во фрагментах текста. Т.е. текст аккуратно раскидан по фрагментам. Возможно, это листинг, возможно, это очень хорошая вёрстка – там, где очень структурированный контент, разбит на хорошие блоки и очень хорошо читается по верстке.

Однако мы увидим, что если ключевые фразы разобрать на слова, они будут встречаться более часто.

Что ещё нужно для того, чтобы составить хороший контент?

Представим, что нам нужен SEO-текст. А кто встречался с фильтром “Баден-Баден”, то уже знают, что наказать могут не только за переоптимизированный или плохой текст, а вообще за текст, не раскрывающий суть запроса, или вообще контент, который не нужен на странице, который не читают.

Он может быть скрыт внизу, до него не доходят, и, собственно, не читают. А чтобы сделать текст более привлекательным, имеет смысл попадать в интерес пользователя.

Можно делать это вручную, сканировать сайты из поисковой выдачи, смотреть самые популярные слова из них, о чём пишут.

Можно использовать сервисы, которые делают то же самое и автоматизируют. Есть сервисы, которые используют нейронные сети. Правда, вряд ли пока это кто-то поставил на широкую ногу, но всё же. Что делаем: мы собираем слова, которые характеризуют тематику.

Мы, по крайней мере, точно понимаем, о чём должен быть текст и о чём его нужно писать. Писать текст просто ради того, чтобы он был, никакого

смысла сейчас нет.

- Проверяем необходимость текста с помощью текстовых анализаторов.

- Если мы пишем текст, то пишем его с чётким смыслом.

- Текст должен быть максимально хорошо размещён. Это не должна быть портянка с разбитыми абзацами, а с инфографикой, с таблицами, и хорошо, чтобы он читался и визуализировался.

На что обратить внимание при использовании любых текстовых анализаторов.

То, что сравнивать себя нужно с сайтами своего типа, об этом я уже успел сказать.

Ни в коем случае не нужно сравнивать коммерческие сайты с Википедией. Это самый банальный пример. Или, например, коммерческий сайт,

коммерческую страницу со страницей статьи на коммерческом сайте. Т.е. тоже сайт вроде бы коммерческий, тот же магазин, но вытаскивается статья из блога или из раздела статей, и нельзя сравнивать вхождение коммерческой страницы листинга, если мы у себя двигаем листинг, с информационной страницей на другом сайте-магазине. Это первый момент.

Второй момент. Если вы сравниваете и увидели, что в ТОПе всё хорошо, все сайты вашего типа, но возникает вопрос: открываете какие-то данные и

видите, что у некоторых сайтов по 5-6 товаров, а у некоторых – по 50. Что делать в этом случае?

В этом случае – либо менять так, как у большинства в ТОПе, либо сравнивать себя с теми, кто в ТОПе, и кто максимально похож на вас.

Хорошо бы, помимо того, что я рассказал, еще и собирать возраст сайтов, доменов из ТОПа, чтобы знать, кто близок к вам. Возраст страниц, чтобы

знать, кто близок к вам. Объем страниц и общую видимость сайта, чтобы понимать, что у сайта не один запрос в ТОПе, по какой-то случайности он

вышел.

Но пока текстовые анализаторы этого не делают.

Сайт совсем не ранжируется

Бывают такие случаи, что мы написали тексты, сделали запросы, разбили ключевики на кластеры, много всего подготовили, но сайт не заходит в ТОП-50, а если совсем всё плохо, и в ТОП-100. Он застрял и никаким образом не двигается в выдаче и крайне плохо ранжируется по основным запросам.

Проблемы ранжирования в Google

Давайте мы рассмотрим ситуацию, когда вс` плохо с Гуглом. Допустим, с Яндексом все более-менее хорошо, но все плохо с Гуглом.

В этом случае в первую очередь нужно обратить внимание на ретроспективу – посмотреть прошлое. Возможно, сайт был наказан когда-то раньше, во времена еще тех фильтров, когда апдейты были в определенные даты (например, “Панда” или “Пингвин”), и посмотреть, не пострадал ли сайт, когда-то давно.

Что делать? Искать причины. Как правило, они всегда находятся. Это может быть плохое техническое состояние сайта. Например, много дублей,

неуникального контента, в целом сайт не очень.

Определяем тип санкций и далее проводим работу:

- Panda – плохое техническое состояние сайта, переоптимизированный и/или малополезный контент.

- Penguin – большое количество SEO-ссылок.

- Mobile-Friendly – нет мобильной версии сайта (или адаптивной вёрстки) или версия плохая.

- Phantom – несоответствие страницы интенту пользователя, низкое качество сайта (техническое в том числе).

Может быть переоптимизированный или малополезный контент именно с точки зрения Гугла. Т.е. нужно делать сайт лучше, если у нас есть проблемы с дублями, с уникальностью, качеством и т.д.

Если начало падения трафика совпало с датой апдейта Пингвина – нужно чистить ссылочную массу. Особенно старую на тот момент. Тем более, если есть арендные ссылки, можно и нужно их чистить.

И Яндекс, и Гугл сейчас не любят арендные ссылки (Яндекс в большей степени). Поэтому имеет смысл вообще снять лишние ссылки, которые вообще плохие, они уже устарели, что называется, протухли (ссылочная масса имеет такое свойство, особенно арендная). И провести работу с инструментом Disavow-links, если раньше эту работу не проводили.

Соответственно, в первую очередь обратите внимание на коммерческие анкоры, прямые вхождения и максимально некачественные доноры.

Если нет мобильной версии, и видим проседание на графике, связанное с этим, то нужно понимать, что нам нужно двигаться в сторону мобильной

версии. Смотреть на даты апдейтов и понимать, что и как нам нужно изменить.

Бывают ситуации, когда я Яндексе всё хорошо (очень хорошая отработка, очень хороший трафик), а Гугл при этом на уровне нуля, и при этом шлейфа истории в принципе нет. Так бывает у молодых сайтов.

В этом случае нужно внимательно отнестись:

- к текстам, потому что Яндексу может и не понадобится текстов для коммерческих запросов;

- к ссылкам. Есть примеры, где банальная закупка ссылок приводила к росту сайтов в Гугле. Тут главное – не переборщить, потому что есть еще Яндекс.

Иногда приходится делать очень странные вещи. Например, делать страницы отдельно для Гугл и отдельно для Яндекс. Там, где совсем радикально по разному нужно построить контент, например, большую портянку для Гугла, а для Яндекса вообще портянка не нужна, в этом случае имеет смысл делать разные страницы и работать с ними по отдельности. Но, как правило, до этого доходит очень редко. Но бывает и такое.

Проблемы ранжирования в Яндекс

В Яндексе все проблемы связаны с тем, что сайт часто попадает под санкции, либо у молодых сайтов они вообще не ранжируются.

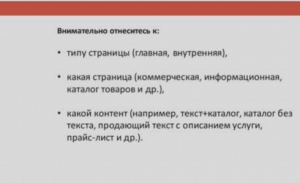

Тут нужно внимательно отнестись к следующим вещам:

- Тип страницы (главная/внутренняя).

- Какая страница (коммерческая, информационная, каталог товаров и др.)

- Какой контент (например, текст+каталог, каталог без текста, продающий текст с описанием услуги, прайс-лист и др.)

Важно со всей внимательностью отнестись к тому, о чем я уже сегодня говорил.

К типу страницы, которую мы выбрали для продвижения, вообще к типу сайта в целом. Что мы продвигаем, соответствует ли это тем запросам, которые мы выбрали.

Возможно, мы пытаемся продвинуть сайт о чём-то по коммерческим вопросам или у сайта мало точек входа, мало посадочных страниц, и мы пытаемся делать большие кластеры и их двигать. Это часто встречается.

Или, например, плохая структура… Т.е. просто тип сайта не соответствует тому, что в ТОПе. Нужно сравнивать себя с успешными сайтами, смотреть, какой у них контент, смотреть, какая у них заполняемость, чего хватает, чего не хватает.

Анализируем качество сайта и контента:

- Коммерческий аудит+юзабилити.

- Анализ конкурентов на содержание.

- Индексация/перебивка релевантных страниц.

- Качество контента (санкции).

Имеет смысл провести полностью коммерческий юзабилити аудит сайта.

Вот если с сайтом всё вообще плохо, привести сайт, с точки зрения пользователя, в более качественное состояние. Сделать его более удобным

для покупки, если это коммерческий сайт. Более читабельным, если это информационный сайт.

Провести юзабилити аудит на удобство: что, как, где, откуда. Чтобы людям было удобно.

Провести аудит конкурентов на содержание – это, так называемая, полнота сайта. Чего не хватает, что нужно сделать, какой раздел добавить. Возможно, по количеству страниц вы проигрываете очень сильно.

Для коммерческих сайтов в коммерческом аудите есть такой пункт – ассортимент. Им тоже ни в коем случае не нужно пренебрегать, потому что ассортимент – достаточно важный пункт. Если у вас 100 товаров, а у всех несколько тысяч – вы будете проигрывать по этому пункту достаточно серьёзно.

Обратите внимание на такие простые вещи, как выпадание страниц из индекса. В Яндексе достаточно часто такое бывает, и страница признаётся некачественной, и она, естественно, не ранжируется.

К тому же, очень часто случается смена релевантных страниц. Нужно наблюдать за этим внимательно. Если ваши страницы часто перебиваются, нужно определить причину: либо это какая-то переоптимизация или переспам на странице, которую вы пытаетесь продвигать, либо пользователям больше нравится другая страница.

Тут нужно подумать, вплоть до того, чтобы скрыть от индексации на время ту страницу, на которой перебивается, и посмотреть, что будет происходить в этом случае.

Качество контента. У нас за все время “Баден-Бадена” всего один сайт попал под санкции, и тексты у него были отнюдь не плохого качества.

Однако сама суть – текст не читают. Мы проверили и посмотрели, что текст просто не читают люди. Он не в том месте расположен, его люди не читают – сайт не ранжируется. Соответственно, нужно понимать, что это либо качество контента, либо какой-то фильтр – за этим нужно смотреть и бороться.

Вопросы и ответы

Теперь я отвечу на популярные вопросы по продвижению сайтов и проблемам с ранжированием.

Нужно ли учитывать ссылочную массу конкурентов при оценке сложности продвижения?

На самом деле – да. Мы оцениваем и смотрим на ссылочную массу (правда, это происходит отдельной работой) при составлении ссылочной стратегии.

Т.е. мы смотрим, какая ссылочная масса – это первое. Вообще объём в целом. Смотрим соотношение разных доноров, доменов к количеству страниц. Мы смотрим, есть ли сквозные ссылки, какого они типа и т.д.

Далее мы смотрим, какая структура ссылочной массы у конкурентов: смотрим форумы, доски объявлений, арендные ли это ссылки, статьи, отзовики и т.д. Смотрим, есть ли пересечения – некий обязательный набор.

Допустим, выгружаем 10 сайтов с максимальной видимостью в тематике, кроме монстров, естественно, и смотрим, есть ли у них пересекающиеся

доноры. Если они есть, то в первую очередь будем делать это. И, исходя из анализа, мы принимаем решение: какая структура ссылочной массы нам нужна, примерно какой объём ссылочной массы нам нужен, и третье – какие анкоры, и что мы будем делать в первую очередь.

По скольким кластерам может продвигаться одна коммерческая страница?

По факту – по одному. Если получилось так, что у нас несколько кластеров и под них выбирается одна релевантная страница, то мы объединяем эти

кластера в один.

И в этом и суть, я рассказывал – проверить, когда у нас после кластеризации получилось много кластеров, возможно ли их объединить в один. И

наоборот, если у вас мало кластеров, или просто какие-то крупные кластеры, можно или нужно ли разъединять запросы.

Как правило, это делается уже опытным оптимизатором. Не только опираясь на опыт, но и на ряд сопутствующих факторов. Например, возможно ли

оптимизировать с точки зрения текстовой оптимизации всю страницу под кластер запросов без какого-то переспама. Все ли зоны (title, H1, фрагменты, плентинг, зона А) можно ли насытить вхождениями слов. И просто опираясь на здравую логику, возможно ли в рамках одной страницы объединить кластеры.

На примере было про маникюр: «цена», «салон красоты», «сделать» – всё было объединено в один кластер с точки зрения логики. Там никакого

шаманства, опыта – просто с точки зрения здравой логики, что это один и тот же интент пользователя. Было объединено, и одна страница продвинулась спокойно в поисковой системе.

Посоветуйте бесплатный сервис кластеризации.

https://arsenkin.ru/tools/

http://coolakov.ru/tools/

Может ли распределение SEO-текста на блоки (например, на отдельные html-элементы) и разбавление страниц дополнительным контентом (картинками, графиками, видео) восприниматься поисковой системой положительно? Как минимум, без санкций? Или в текущих условиях нужно ориентироваться только на смысл запроса и текста?

Глобально – да. Если текст описывает ту проблему пользователя, с которой он пришёл на страницу, то гораздо лучше он будет ранжироваться, если его снабдить инфографикой, разбить на блоки, добавить видео, таблицы – т.е. хорошо его сверстать. Это будет гораздо лучше, чем просто полотно текста, естественно.

Но если контент – не о чём, бессмысленный, текст ради текста – конечно, каким-то плюсом будет его разбитие на блоки, добавление картинок, чего-то ещё. Но если он бессмысленный, то он в принципе не нужен всё-равно.

Как можно рассчитать видимость сайта отдельно по коммерческим и по информационным запросам (например, отдельно для блога и для каталога)?

Мы делаем следующим образом. Это непростая задача в целом. Мы считаем сначала общую видимость по запросам. Т.е. мы берем видимость в тематике и смотрим, какие сайты там хорошо ранжируются.

Дальше мы смотрим на тип сайтов. Бывают просто сайты о чём-то (информационный сайт) – в этом случае мы подразумеваем, что вся его видимость, даже если по коммерческим запросам, то всё равно сайт информационный, и мы, скорее всего, вообще с ним себя ассоциировать не будем.

У коммерческих сайтов мы смотрим популярные URL. Практически любой сервис позволяет это делать. На том же Мегаиндексе можно посмотреть,

какие урлы наиболее популярны на сайте, с точки зрения органических переходов. И какие запросы на этих урлах ведут.

Т.е. мы не считаем с точностью до каждого запроса, но примерно в процентах объём трафика (информационного или коммерческого), исходя из того, сколько страниц и сколько на себя процентов трафика они, с точки зрения сервисов, забирают – мы смотрим и получаем примерную картину.

Например, что 10 сайтов, с которыми мы себя сравниваем, у первого сайта – 70% информационный трафик, 30 – коммерческий. У следующего 40/60 и т.д. И мы в итоге понимаем, нужно ли нам делать какой-то информационный кластер на сайте: статейный, блоговый или какой-то еще.

Может ли наличие сайта-сателлита понижать позиции основного сайта в Гугл?

Абстрактный вопрос. Гугл, если именно с точки зрения аффилирования, то такого, как в Яндексе, у него нет. Там проблемы могут быть с уникальностью контента, если там один и тот же контент, или если он очень схож.

Просто сателлит может быть более релевантнее и тогда проблемы с ранжированием будут у основного сайта. И вторконтент в Гугле в принципе нормально живет, и копипаст контент тоже в Гугле нормально живет. Главное, чтобы сайт в целом был ничего.

А по поводу того, что сателлит будет мешать в Гугле – вряд ли. Скорее всего, если это коммерческие ресурсы, то проблемы будут в Яндексе.

Как называется инструмент для чистки ссылок?

Инструмент называется “Disavow-links”, который доступен в инструментах для вебмастеров Гугл.

Ссылочку непросто найти в Google Search Console, но можно, если покопаться. А проще всего, кстати, просто в Гугле забить «Disavow-links», и

он выдаст прямо ссылку на инструмент.

Он позволяет отклонять ссылки. Допустим, у нас есть 100 ссылок, и мы не хотим, чтобы 50 из них участвовали в расчёте ссылочного ранжирования нашего сайта. Мы можем отправить их списком в этот инструмент, и они не будут учитываться. А если там были какие-то санкции, то они снимутся, если они были именно из-за этих ссылок.

Но при этом Google пишет:

В любом случае приложите все усилия для того, чтобы удалить искусственные ссылки на ваш сайт. К сожалению, для этого недостаточно просто сообщить, что вы не имеете к ним отношения.

Имеется группа запросов. При проверке данной группы на текстовый фильтр, 3 запроса из 10 показывают переоптимизацию. При расширенном поиске наш сайт выше конкурентов. Если же это переоптимизация, то она накладывается на всю группу запросов, т.е. на 10 из 10? Может быть исключение, но явно более, чем 3 из 10. Вопрос: какие выводы необходимо делать? Данная страница находится под фильтром переспам или переоптимизация?

На самом деле характерно именно для переоптимизации понижение позиций всей группы запросов. Т.е. даже НЧ.

Если диагностируется 3 из 10 – скорее всего, это не переоптимизация. Просто по каким-то причинам методика проверки показывает, что по этим запросам ситуация выглядит, как переоптимизация.

Скорее всего, это даже не переспам. Тут нужно смотреть, как ранжируются другие запросы:

- Если всего 3 из 10 ранжируются плохо, а остальные прям хорошо, и эти 3 из 10 ранжируются в ТОП-20 (максимум в ТОП-30), то, возможно, это переспам.

- Если же эти 3 запроса ранжируются за Топ-40, ТОП-50 – это не переспам, и нужно смотреть ситуацию более подробно. Может быть, вообще проблемы с ранжированием. Может быть, недостаточно вклада каких-то факторов.

А кому нужен текст для категорий? Кто его читает? Что там можно написать полезного, чтобы раскрыть тему?

К сожалению, тут вопрос не в том, нужен ли текст или нет. Вопрос в том, чтобы нам выиграть у конкурентов. В том числе по НЧ запросам. И методика, которая предполагает сбор трафика, она предполагает написание хоть какой-то «генерёжки» или небольшого абзаца текста, чтобы увеличить текстовый ранж по НЧ запросам.

И когда мы писали большие портянки, суть была та же самая: мы хотели как можно сильнее насытить текстовое ранжирование.

По факту мы понимаем, что тексты, скорее всего, не читают, и вряд ли их будут читать. Поэтому тексты стараемся размещать как можно выше, писать как можно проще и то, что нужно людям, и не писать портянки.

И Яндекс как раз направил свои силы на борьбу с беспощадными текстами ради текстов. Но, я думаю, что сложно полностью убить текстовую составляющую… Они, скорее всего, будут присутствовать. Ну, портянки-то умерли уже давно.

Т.е. в любом случае – да, тексты не читают, но текстовое ранжирование никто не отменял.

Может быть связано непопадание в ТОПы с низкой индексацией сайта Гуглом? Например, из 12 тысяч страниц проиндексировано только 4 тысячи?

Проблемы с индексацией вообще характеризуют, что с сайтом есть какие-то проблемы. Т.е. робот не хочет брать в индекс страницы. Они могут быть

некачественными, с точки зрения робота. Они могут быть не уникальными.

И, соответственно, может быть так, что и про другие страницы так же считает алгоритм, что с ними тоже всё плохо.

Поэтому стоит обратить внимание на качество сайта. Второе – попробовать доиндексировать страницы.

Например, подкидывать на страницах список не проиндексированных ссылок. По несколько ссылок (по 2-3-4 ссылки) подкидывать на разных страницах, куда заходит робот – посмотреть, будут ли индексироваться эти страницы. Если они в индекс принципиально не заходят – значит, проблема глобально с качеством сайта.

И нужно смотреть, в чём именно: дублирование, техническое состояние, уникальный контент, вообще качество контента, попадание в интент запросов.

Может быть, там вторконтент, который не несёт никакой ценности – т.е. еще один сайт из многих. Возможно, в этом проблемы. А не то, что нет в индексе столько-то страниц, а другие поэтому плохо ранжируются. Нет, это не прямая взаимосвязь.

И первым пунктом, чтобы проверять, очень часто забывают – начните с robots.txt. Возможно, там какая-то ошибка. Вот зачастую лезут в глубины, а всё на поверхности.

Что делать, если в анализаторе показывает, что вхождения не нужны, а, пробегаясь по ТОПу, в пяти сайтах вхождение присутствует?

Тут вопрос в анализаторе. Поэтому в любом случае проверяем ещё вхождение слов в те зоны. Это первое. Второе – если мы говорим про любой анализатор (платный или бесплатный), нужно понимать, что это механизм, это скрипт, который может ошибаться.

Т.е. если он не раскладывает на разные вариации запросов, если он не лимонитизизует, или может быть произошла ошибка в лимонитизации – это всего лишь инструмент, который нужно проверять.

На самом деле это так. И проверять приходится. У себя мы это видим, и у ребят. Это нормально, и поэтому перепроверка тоже достаточно важна.

Один из примеров – это запросы с тире. Как их считать? Без тире или всё-таки правильно учитывать с тире? А если человеку нужно, чтобы именно с

тире? Или без тире? Есть такие нюансы.

Есть ли смысл покупать ссылки у крупных СМИ за очень много денег? Или размазать бюджет на множество ссылок подешевле?

Вопрос необходимости. Если мы говорим о крупных СМИ и больших деньгах, это вообще к SEO особо не относится. Ну, относится, но косвенно.

Это больше относится к пиару. Получение качественной ссылки с большим количеством переходов, с пиар-эффектом, с маркетинговой целью, чтобы

были заказы и заявки. С точки зрения SEO, лучше немножко размазать и получить ссылки попроще, но побольше. Но также, чтобы были какие-то переходы, и чтобы люди пришли.

Но если говорить 1 – за 100 тысяч или 5 – за 20, то я выберу, как сеошник, 5 – за 20. Но, опять же, тут еще вопрос в пиаре и в маркетинге еще.

Как узнать, есть ли сейчас санкции со стороны Гугла?

Да, проблематично. Раньше мы знали даты апдейтов, приходили письма счастья. Сейчас мы просто наблюдаем за трафиком в Гугле, смотрим на

вебмастер, на проблемы с индексацией. И принимаем какое-то решение, исходя из того, упал трафик, что находится в веб-мастере, индекс упал или

какие-то проблемы обозначаются.

Если упал трафик, и проблем нет, то ищется причина, что может быть. Закупали ссылки – значит, это могут быть ссылки. Знаем, что что-то не очень с сайтом – соответственно, на это обращаем внимание.

Определить сейчас всё, что встроено в алгоритм, уже достаточно сложно.

Разбавление контента инфографикой более выгодно со стороны ранжирования, как более юзабельное, на взгляд пользователя?

Коротко – да.

Если всё сделать правильно, в течение какого времени обычно сайты выходят в ТОПы?

Разграничу так:

- НЧ запросы – они могут выйти сразу после апдейта на дату внедрения изменений (неделя-две-три). Внедрили – переиндексация – сайт сразу же растёт.

- СЧ запросы: там чуть подольше. Там если всё сделано корректно, прямо сразу и на всём сайте, то возможен выстрел, как по НЧ, а

возможно придётся подождать, пока чуть-чуть подкопятся ПФ и пересчитаются другие факторы – от нескольких недель до 1,5-2 месяцев. - ВЧ запросы – бывает по-разному. Бывают резкие взлёты, а вообще требуется какое-то время, чтобы сайт накопил ПФ, пересчиталась ссылочная, все

коммерческие факторы отыграли – это обычно 2,5-3,5-4 месяца. Т.е. тоже всё достаточно быстро, если не подкинуло.

Но, как правило, для СЧ и ВЧ запросов приходится что-то докручивать. Т.е. сделали, получили какой-то результат, докручиваем. Особенно, если страница новая, она только создалась.